Früher oder später stößt jeder Webmaster auf die robots.txt-Datei. Diese Textdatei gibt den Crawlern von Suchmaschinen wie z.B. Google Anweisungen, welche Bereiche einer Website sie besuchen dürfen und welche sie ignorieren sollen.

In diesem Artikel erkläre ich dir, wie du die optimale robots.txt-Datei für deine WordPress-Seite erstellst. Wir gehen sowohl auf die Standardkonfiguration von WordPress ein, als auch darauf, wie du sie manuell anpassen kannst – entweder durch ein Plugin oder direkt im Dateisystem.

Was ist eine robots.txt und warum ist sie wichtig?

Die robots.txt ist eine einfache Textdatei, die sich im Root-Verzeichnis (= das Hauptverzeichnis auf oberster Ebene, wo auch deine wp-config.php liegt) deiner Website befindet.

Sie sagt Suchmaschinen-Bots, welche Seiten und Verzeichnisse sie crawlen dürfen und welche nicht. Das hilft dabei, unnötigen Traffic durch das Crawlen irrelevanter oder privater Bereiche zu verhindern.

Für große Websites mit mehreren tausend Unterseiten ist es wichtig zu wissen, dass die robots.txt-Datei auch dazu beitragen kann, die Crawling-Effizienz zu verbessern. Eine gut optimierte Datei sorgt dafür, dass Google & Co. schnell die relevanten Inhalte deiner Seite erfassen, ohne sich in unbedeutenden Unterseiten zu verlieren.

Die Standard-WordPress robots.txt

Von Haus aus liefert WordPress eine virtuelle robots.txt-Datei, die über die wp-functions.php generiert wird. Diese sieht so aus:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://deine-website.de/wp-sitemap.xmlGehen wir sie kurz durch:

Zeile 1: Alle Crawler (angegeben durch User-agent: *) haben erst einmal Zugriff auf deine komplette Website.

Zeile 2: Das Verzeichnis /wp-admin/ wird für alle Crawler ausgeschlossen.

Zeile 3: Hier wird die admin-ajax.php-Datei erwähnt, die für das Nachladen von Inhalten verantwortlich ist und von diversen Plugins verwendet wird. Diese liegt im zuvor blockierten wp-admin-Verzeichnis, wird allerdings durch die Allow-Anweisung wieder explizit freigegeben.

Zeile 5: Hier wird auf die von WordPress standardmäßig erzeugte Sitemap verwiesen.

Diese Standardeinstellung schützt das sensible wp-admin-Verzeichnis, lässt aber ansonsten alles offen.

Wichtig: Spätestens wenn du ein Plugin verwendest, um eine Sitemap zu erstellen, solltest du eine robots.txt-Datei erstellen und die entsprechende Zeile (in meinem Beispiel Zeile 5) anpassen. Ansonsten werden Crawler ggf. auf eine fehlerhafte Sitemap verwiesen.

robots.txt selbst erstellen

Wenn du mehr Kontrolle über das Crawling deiner Website haben möchtest, kannst du deine eigene robots.txt-Datei erstellen.

Das geht ganz einfach:

- Öffne einen Texteditor

- Füge die gewünschten Regeln hinzu

- Speichere die Datei unter dem Namen „robots.txt“

- Lade die Datei anschließend im Root-Verzeichnis deiner WordPress-Installation hoch (z.B. über FTP)

Wichtig: Sobald du eine eigene robots.txt-Datei hochlädst, überschreibt sie die von WordPress erstellte. Wenn du also zukünftig Änderungen vornimmst, hat deine Datei Vorrang. Diese Datei solltest du also anpassen.

robots.txt über Plugins verwalten

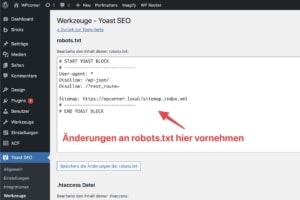

Falls du keinen FTP-Zugang hast oder das Root-Verzeichnis nicht direkt bearbeiten möchtest, kannst du die robots.txt auch über ein Plugin wie Yoast SEO erstellen und verwalten.

Gehe dazu wie folgt vor:

- Navigiere im Menü zu Yoast SEO -> Werkzeuge

- Klicke auf Datei-Editor

- Wenn du noch keine robots.txt-Datei erstellt hast, kannst du über „robots.txt Datei erstellen“ eine erstellen

- Yoast SEO erstellt dir standardmäßig eine Datei, die ebenfalls alle wichtigen Anweisungen beinhaltet. Ebenso wird auf die vom Plugin erstellte Sitemap verwiesen.

- Solltest du bereits eine robots.txt-Datei erstellt haben, kannst du diese Datei in diesem Bereich bearbeiten.

Typische Fehler in der robots.txt und wie du sie vermeidest

Manchmal kann eine falsch konfigurierte robots.txt-Datei deiner Website mehr schaden als nützen. Hier einige häufige Fehler:

- Blockieren von JS- und CSS-Dateien: In der Vergangenheit war es üblich, diese Dateien zu blockieren. Google hat jedoch bereits vor vielen Jahren seine Richtlinien geändert und möchte vollen Zugriff auf diese Ressourcen, um deine Seite richtig zu rendern.

- Zu viel blockieren: Wenn du aus Versehen wichtige Verzeichnisse wie

/wp-content/blockierst, könnte das dazu führen, dass Google wichtige Inhalte deiner Website nicht erreicht.

Tipp: Nutze Tools wie die Google Search Console, um sicherzustellen, dass deine robots.txt-Datei korrekt funktioniert und keine wichtigen Ressourcen blockiert werden.

Fazit: robots.txt nicht vernachlässigen!

Die robots.txt ist ein wichtiges Werkzeug, um Crawler zu steuern und sicherzustellen, dass sie nur die relevantesten Teile deiner Website durchsuchen.

Ob du dich für den minimalistischen WordPress-Standard oder eine detailliertere Konfiguration entscheidest – achte darauf, deine Datei regelmäßig zu prüfen und anzupassen, wenn sich deine Website-Struktur ändert.

Denk daran: Halte sie einfach, trag deine Sitemap ein, und blockiere nur das, was wirklich notwendig ist.

Häufig gestellte Fragen zur robots.txt in WordPress

Die robots.txt-Datei wirft häufig Fragen auf, besonders wenn es darum geht, sie für Suchmaschinen zu optimieren. Hier findest du Antworten auf einige der häufigsten Fragen, die helfen, das Thema besser zu verstehen und Fehler zu vermeiden.

In einer WordPress-Installation ist es oft sinnvoll, Verzeichnisse wie /wp-admin/ und /wp-includes/ für Crawler zu sperren, da diese keine relevanten Inhalte für die Suche enthalten. Seiten wie Trackbacks, Feeds und Kommentare werden oft ebenfalls ausgeschlossen, um die Crawler zu entlasten. Je nach Website kann es jedoch sinnvoll sein, die Datei individuell anzupassen.

Ja, eine fehlerhafte Konfiguration kann deine Website im Ranking beeinträchtigen. Blockierst du versehentlich wichtige Ressourcen wie CSS- oder JavaScript-Dateien, kann das die Darstellung und Ladezeit beeinflussen, was Google negativ bewertet. Ebenso sollten keine Unterseiten blockiert werden, die wertvollen Content enthalten, da der Crawler diese nicht besuchen kann.

Um sicherzustellen, dass die robots.txt korrekt funktioniert, bietet die Google Search Console ein Tool zur Analyse der Datei an. Damit kannst du testen, ob wichtige URLs richtig zugänglich sind oder ob Probleme auftreten. Ein regelmäßiges Prüfen verhindert Fehler, die das Crawling und Ranking beeinträchtigen könnten.

Falsche Einstellungen können die Indexierung wichtiger Seiten verhindern und das Ranking negativ beeinflussen.